Potřebujete jednoduše, efektivně a pravidelně posílat data do Azure? Výborným způsobem je použít Azure Data Box varianty s online režimem. Konkrétně jde o Data Box Edge, tedy hardwarové řešení, které si můžete pronajmout (hardware nekupujete, Microsoft vám ho zašle). Kromě online posílání do Azure podporuje i IoT Edge, takže na zařízení můžete nahrát logiku pro předzpracování dat včetně Azure Functions, Stream Analytics nebo Azure Machine Learning. My se dnes ale zaměříme na Data Box Gateway - virtuální appliance, která vám zajístí jednoduchý způsob posílání dat do cloudu.

Připravíme si Data Box Gateway

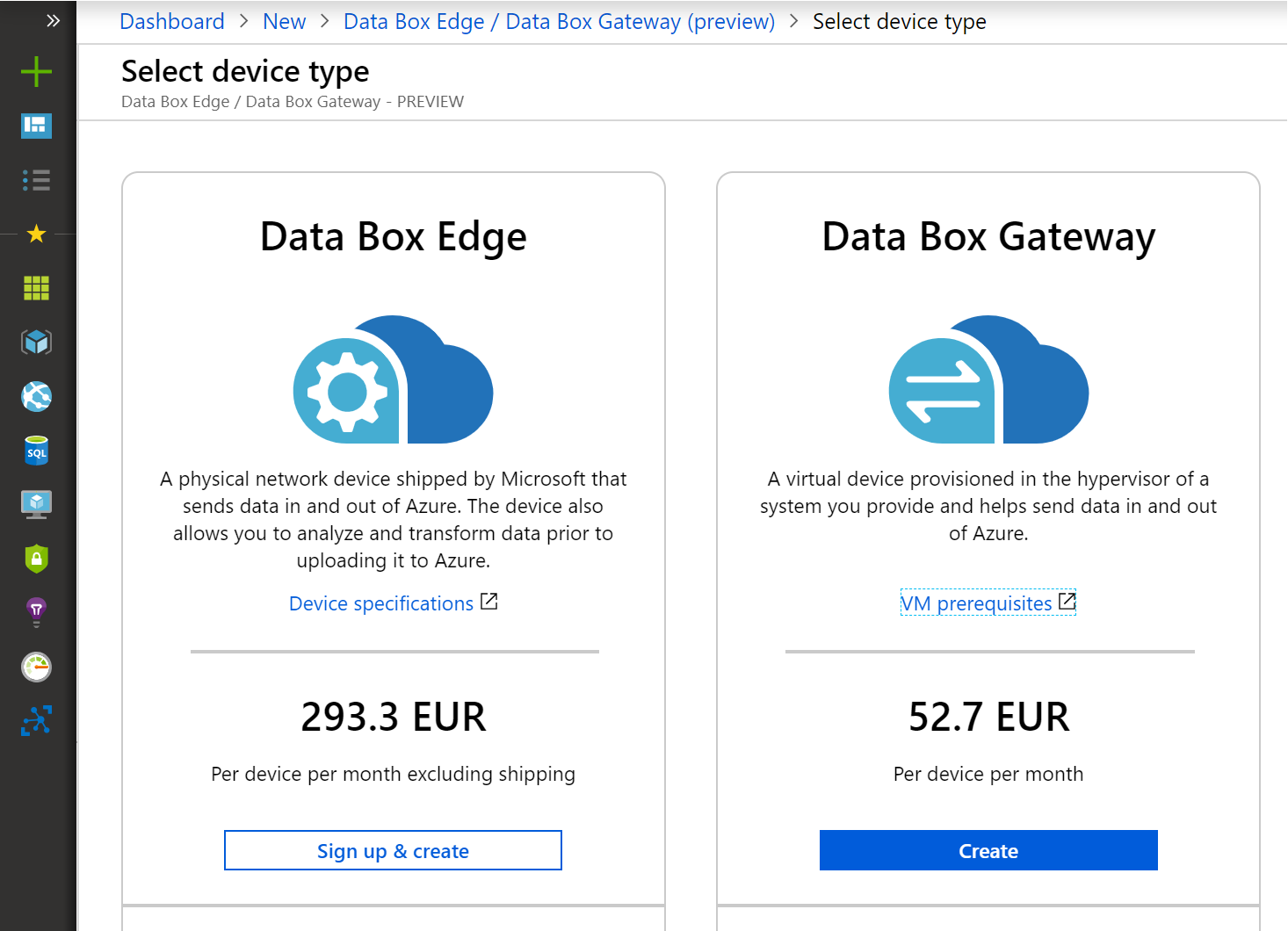

V Azure si přidáme Data Box Gateway a pro online režim si můžeme vybrat pronájem Data Box Edge, my ale použijeme Data Box Gateway, tedy virtuální appliance. Aktuální cenovky reprezentují zlevněné preview s 50% slevou.

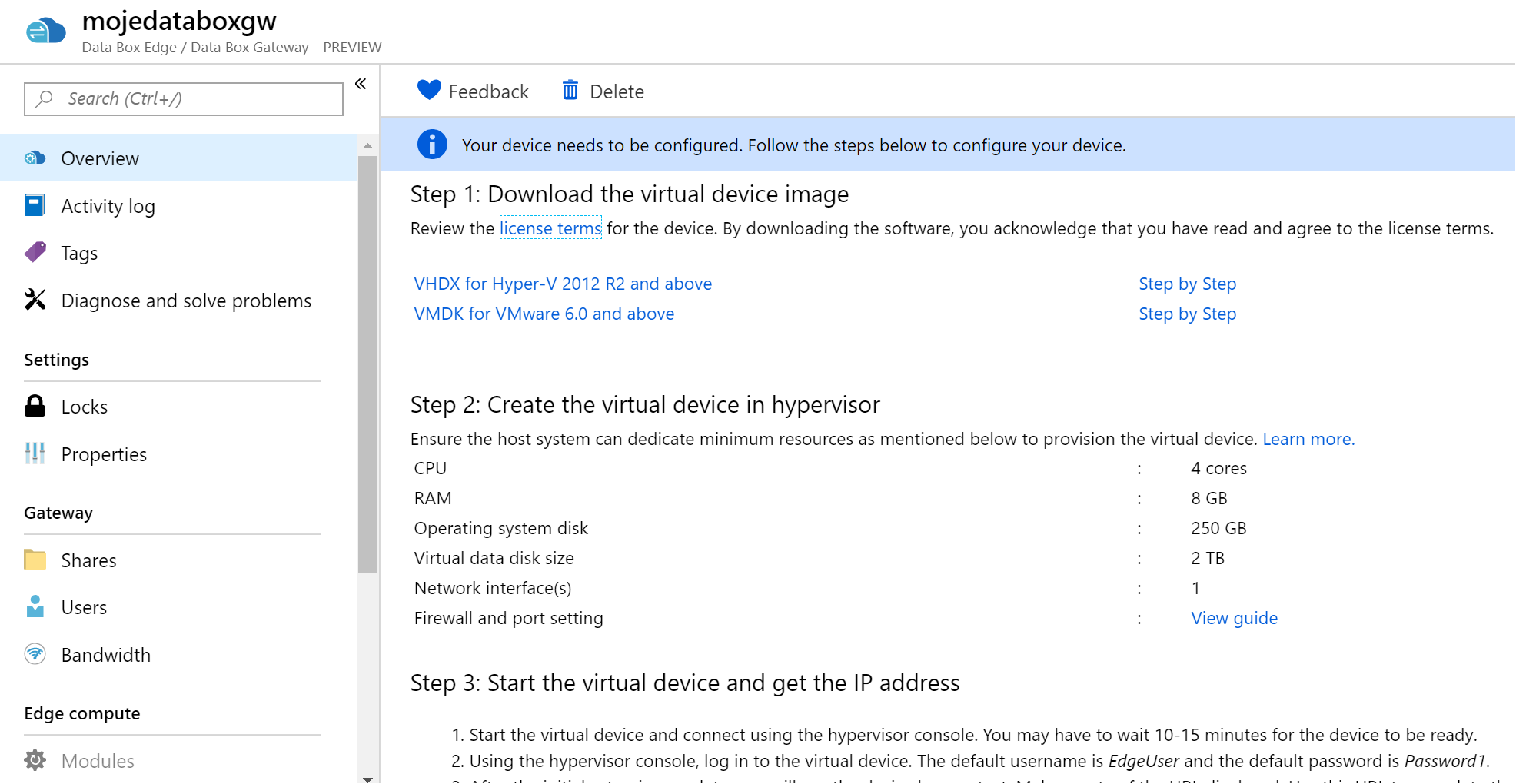

Jakmile bude brána připravena můžeme si stáhnout virtuální appliance pro VMware nebo Hyper-V.

Appliance jsem si nainstaloval v Hyper-V a postupoval podle návodu. Pokud máte potřebu statické IP adresy, použijte příkaz Set-HscIpAddress. Po iniciální konfiguraci se rozsvítí lokální portál pro správu (výchozí heslo je Password1, které budete hned přinuceni změnit).

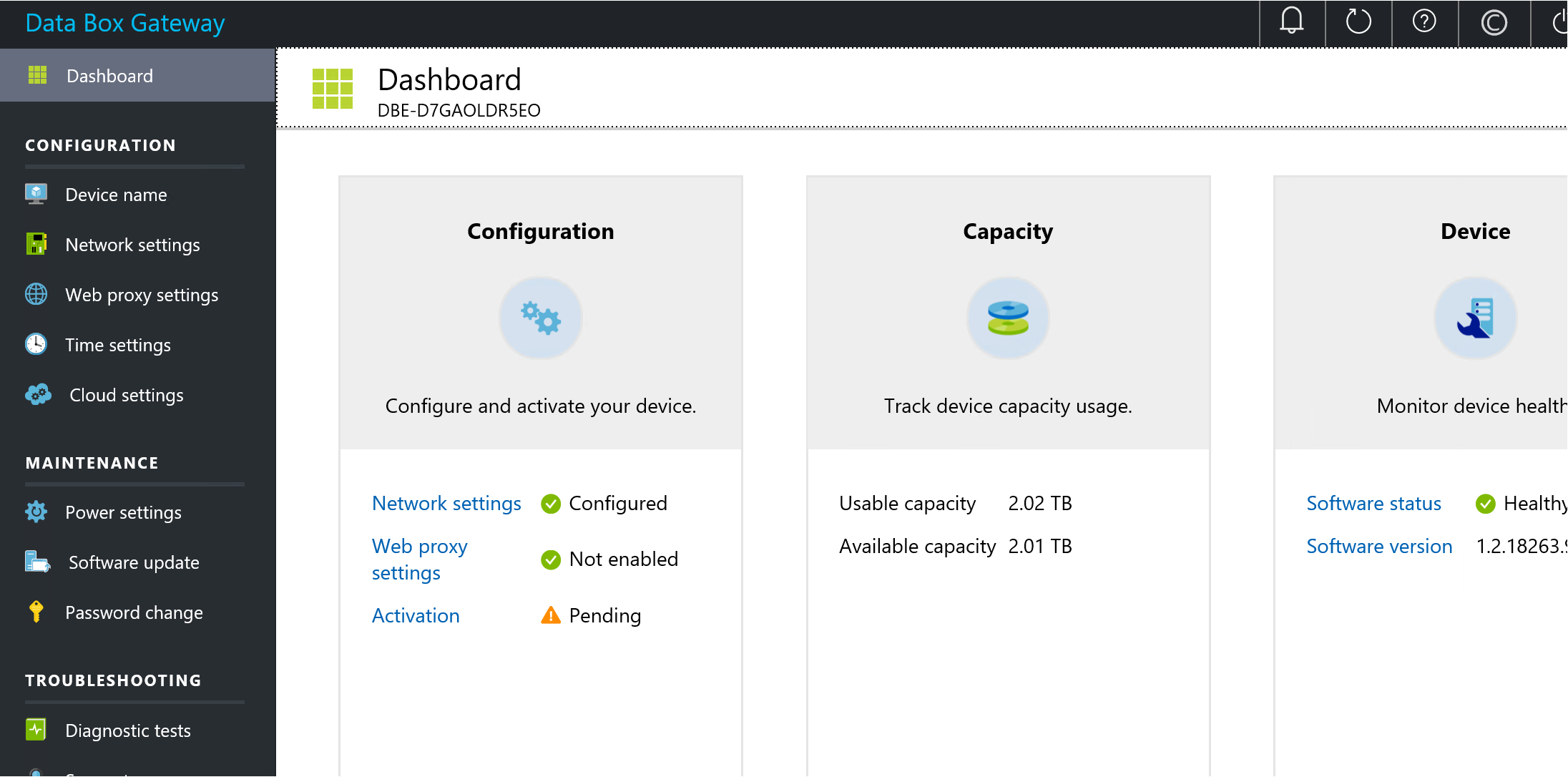

Takhle vypadá lokální portál pro konfiguraci zařízení.

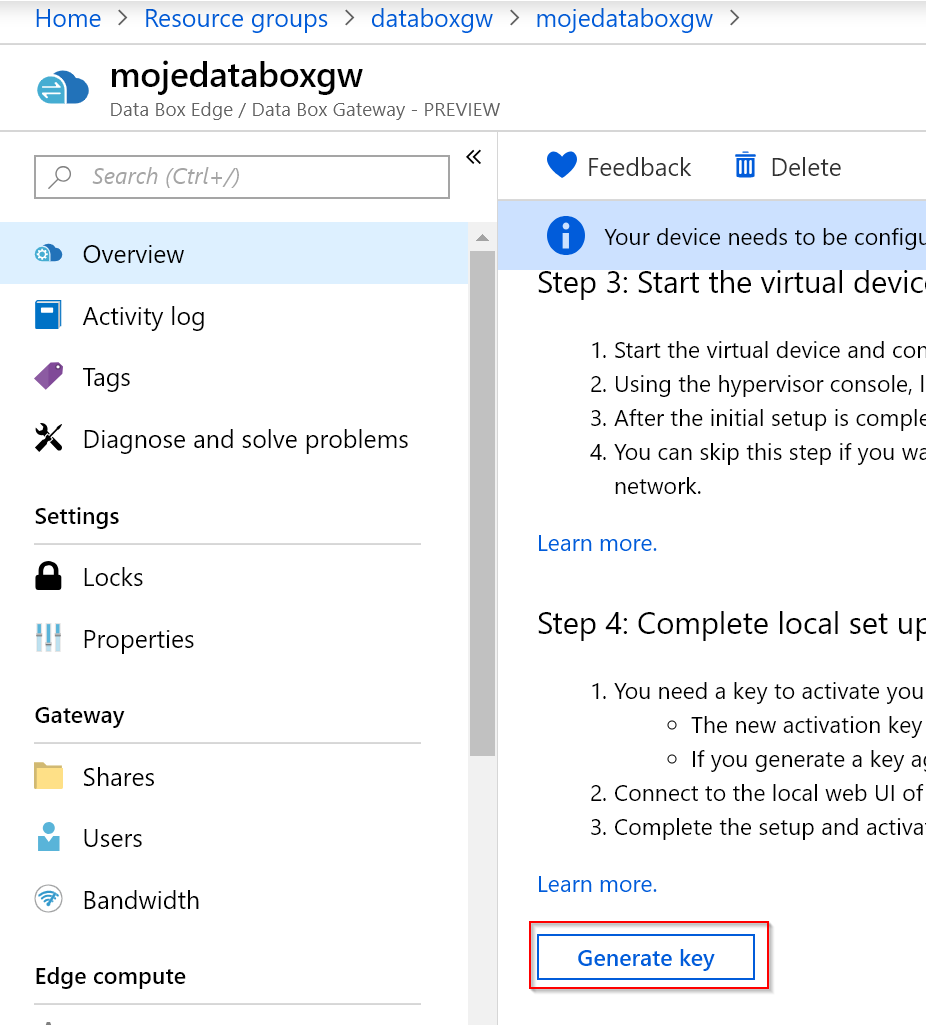

Nejprve půjdu do Azure a vygeneruji si pro něj klíč.

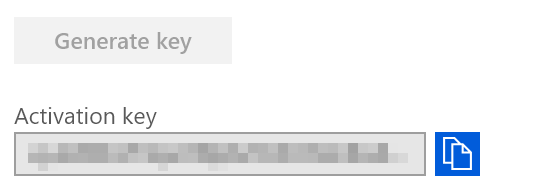

Ten zadám v portálu zařízení.

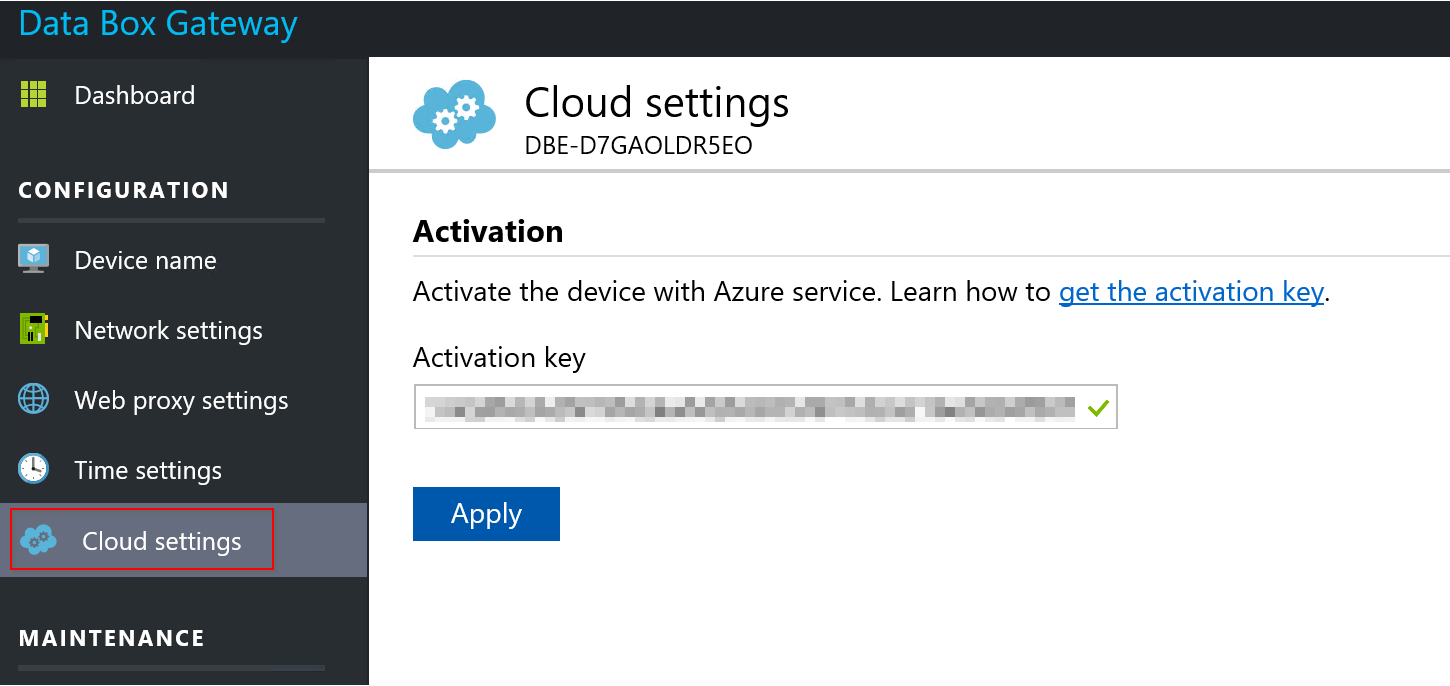

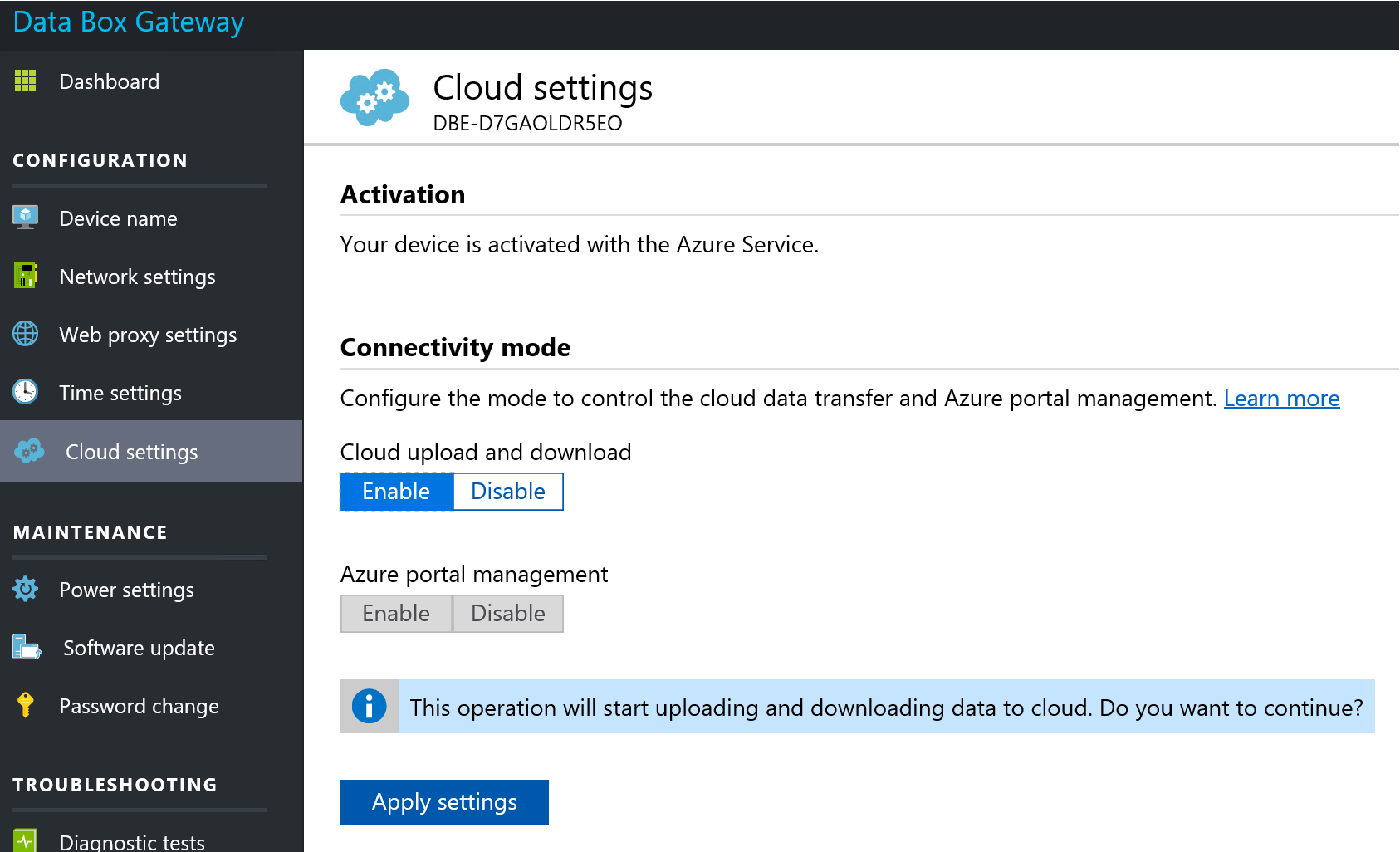

Zařízení dám rovnou do online režimu a aplikuji nastavení.

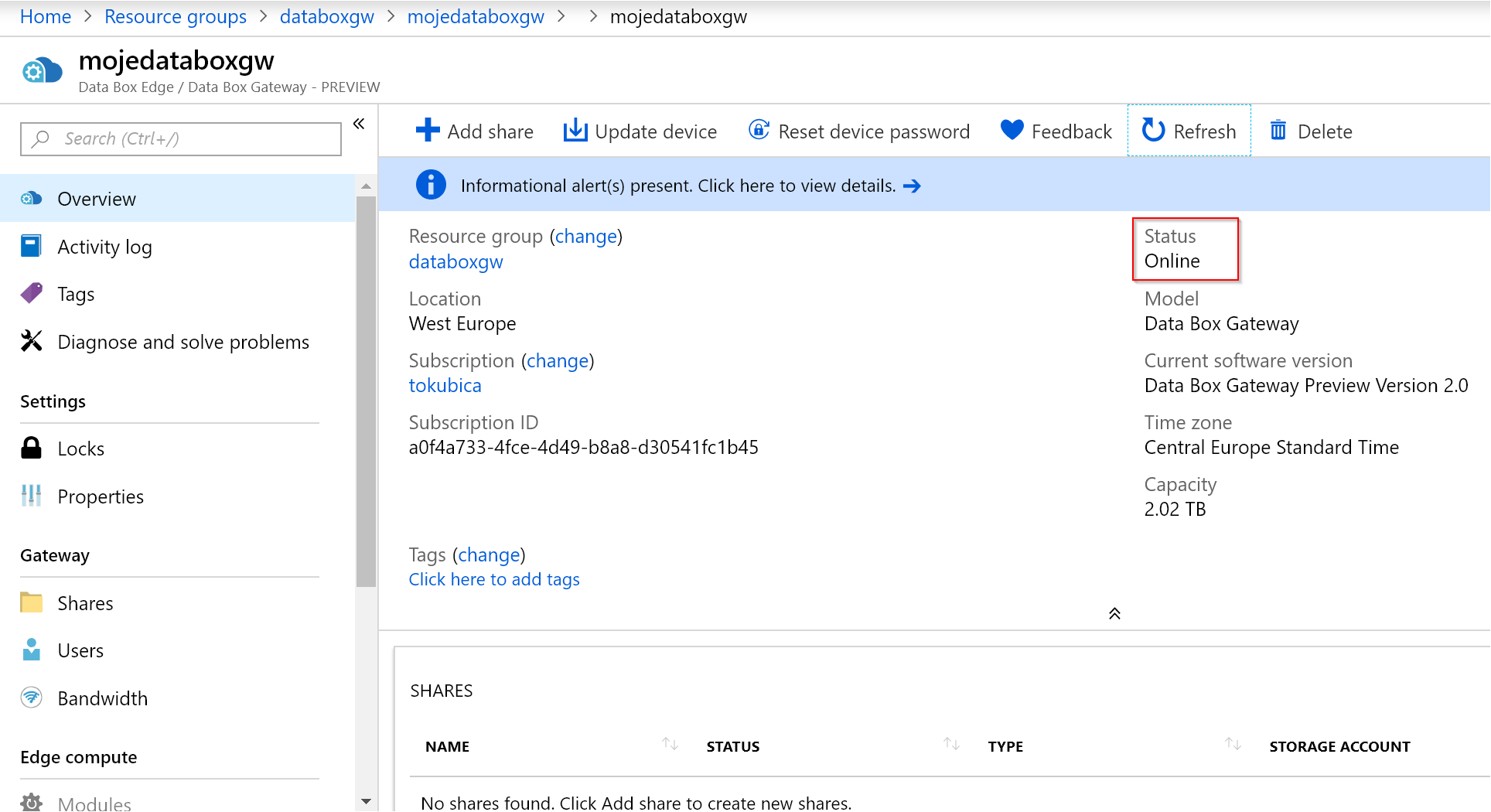

Ověřte, že všechno funguje, je na to testovací tlačítko přímo v zařízení. Pokud ne, opravte co je potřeba - nastavení web proxy, časového serveru apod. Následně už uvidíme zařízení online v Azure portálu.

Od teď už bude probíhat veškerá správa v cloudu, na zařízení už přistupovat nemusíme.

Vytvoříme share a napojení do storage v Azure

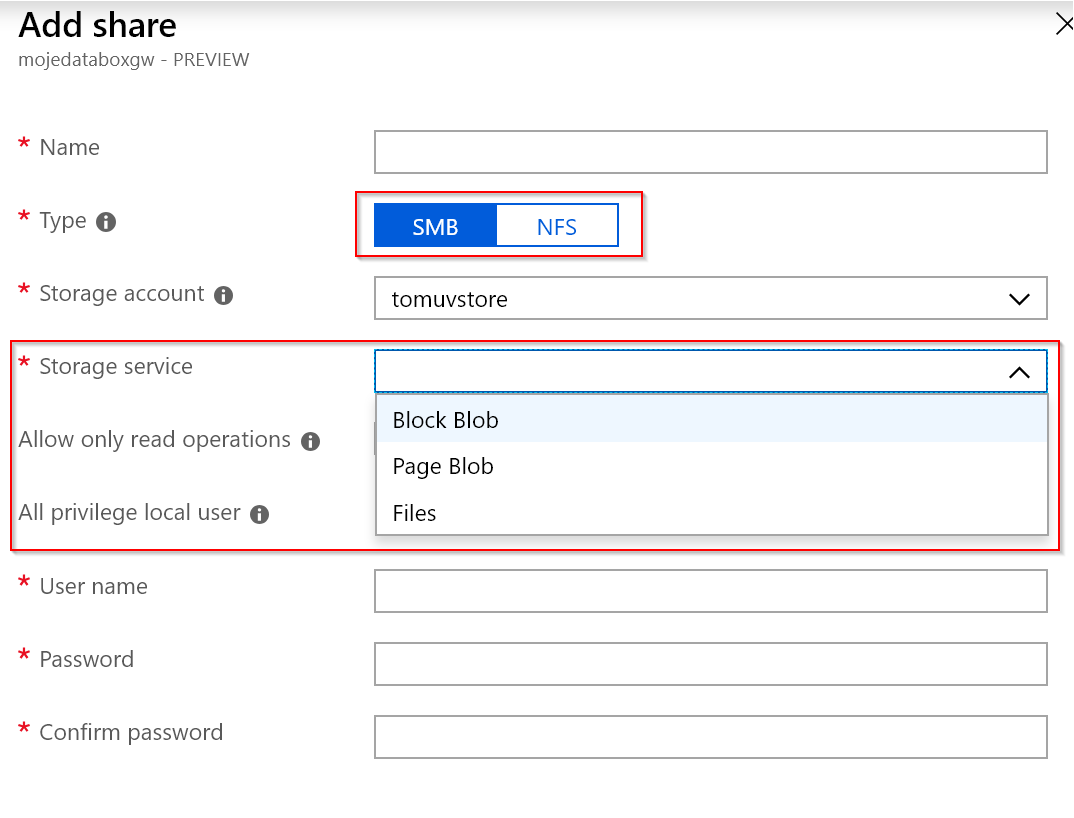

Celý koncept spočívá v tom, že zařízení poskytuje lokální storage interface. Aktuálně je to SMB, ale pro některé případy se vám může lépe hodit univerzální NFS. Pokud jsem správně pochopil na roadmapě produktu je i Blob storage protokol, tedy lokální implementace Blob rozhraní.

Dále share napojíme na storage v cloudu. Perfektní zprávou je, že podporuje nejen Files (podobně jako jednoduchá Azure Files synchronizace), ale i Blob. To je užitečné, protože Blob je nejlevnější způsob uložení dat včetně podpory pro různé tiery jako je Hot, Cool a Archive.

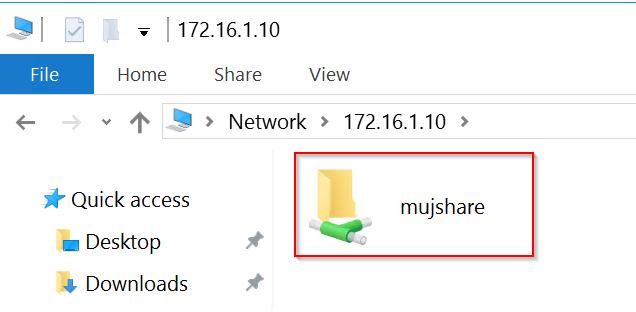

Připojil jsem se na tento lokální share z lokální sítě a nahrál do něj nějaké soubory. Výborná věc je, že to je velmi rychlé a nemusím čekat, až data doputují do cloudu. Nahraji na lokální share a můžu se odpojit a jít domů.

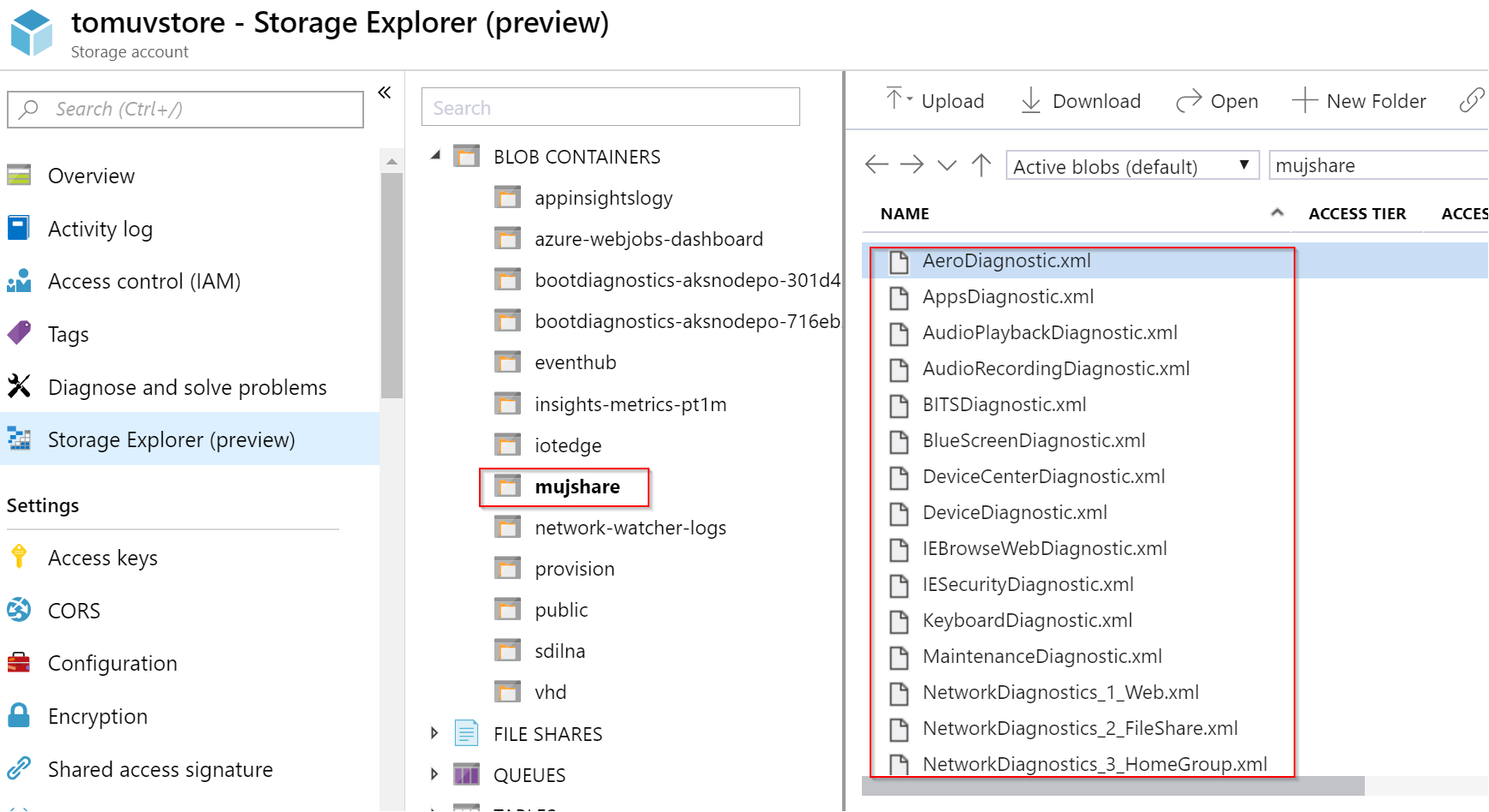

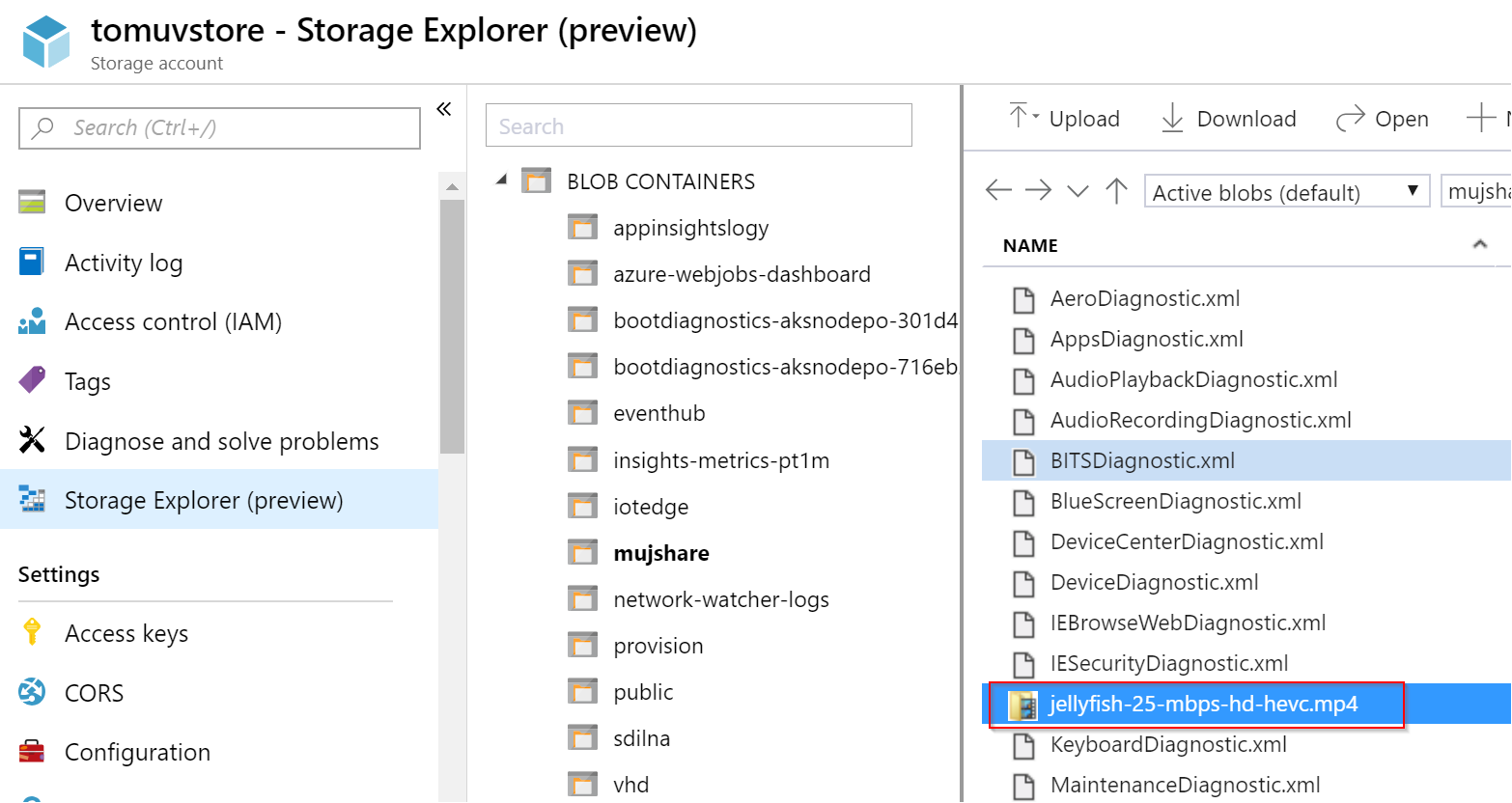

Téměř okamžitě jsou dostupné v mé Azure Blob Storage.

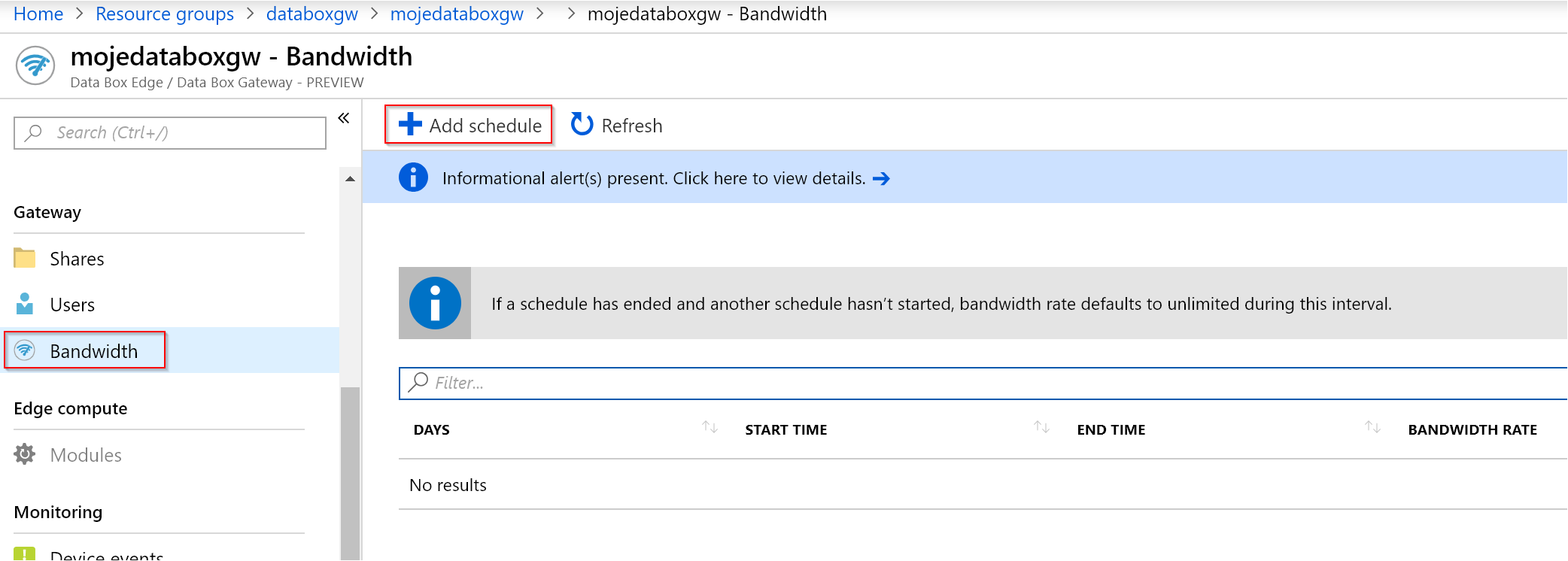

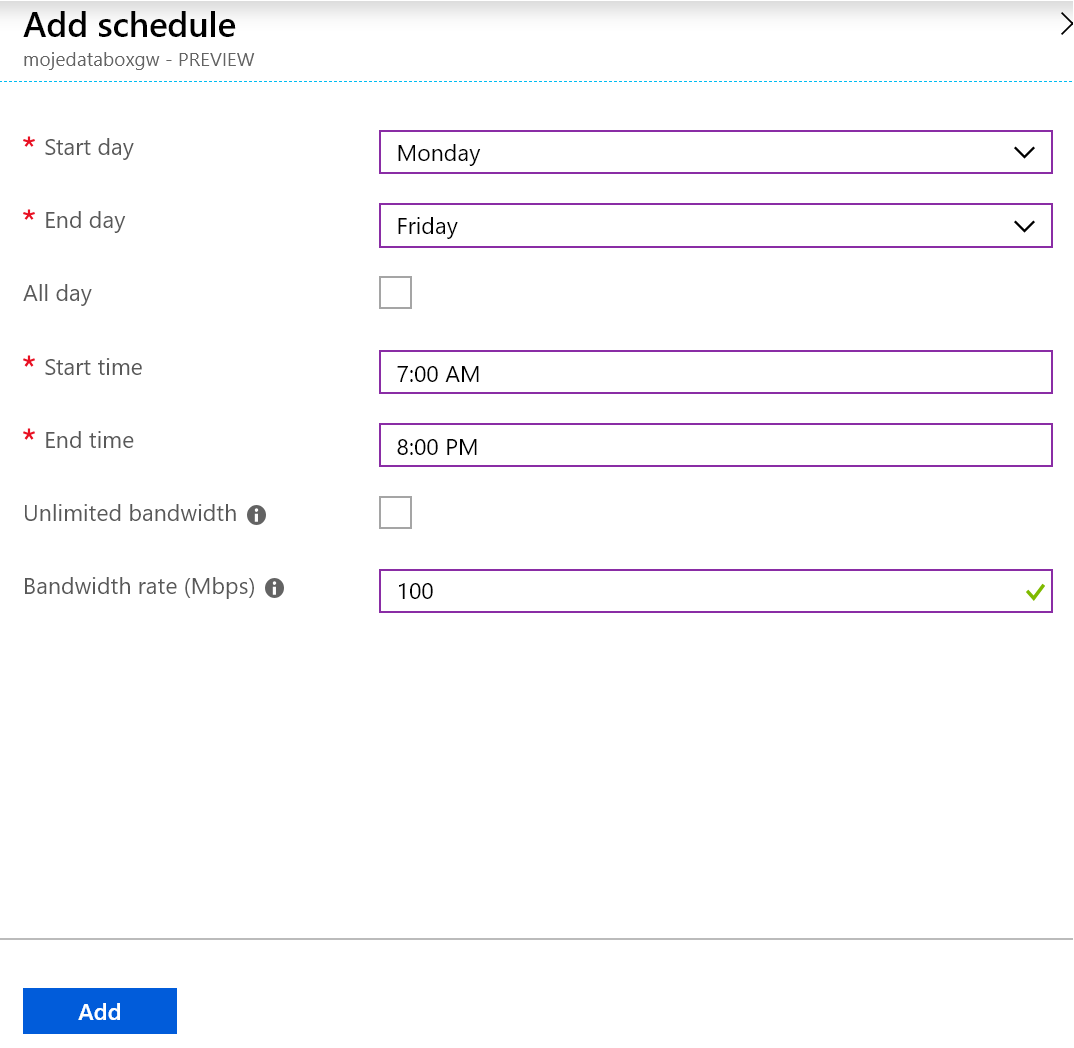

Synchronizace je velmi efektivní. Systém dokáže použít vícero vláken a natlačit data do cloudu opravdu pod tlakem. Někdy až moc, takže může negativně ovlivnit vaše připojení do Internetu zejména v pracovních hodinách. Na to je myšleno a můžete nastavit omezení propustnosti. To se dělá tak, že omezení je možné naplánovat. Dáte tak omezené pásmo v pracovní době a v noci buď neomezené nebo jiné.

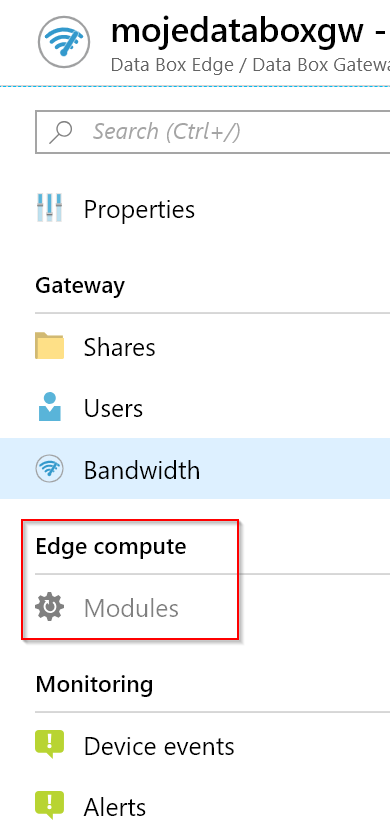

Mimochodem všimněte si záložky Edge compute. Ta je v mém případě zašedlá, protože mám Data Box Gateway. V případě Data Box Edge ale můžu do zařízení poslat moduly ve standardu Azure IoT Edge, o kterém už jsem psal. Může jít například o Azure Function, která bude provádět lokální zpracování dat, například filtraci dat nebo jejich konverzi před odesláním. Také může jít o Azure Stream Analytics, kdy budu chtít do cloudu posílat jen agregované průměry. Velmi zajímavá je i možnost vystrčení Azure Machine Learning modulu. Data Box Edge je výpočetně velmi slušná mašina, takže s tím dokážete dost věcí. Navíc toto zařízení bude vybaveno speciálním FPGA obvodem z Project Brainwave. Bude tedy schopné hardwarové akcelerace ML úloh, takže můžete použít i náročné neuronové sítě a zpracovávat data velmi rychle, efektivně a přímo na krajním zařízení.

Data nahraná do Data Box Gateway se na pozadí kopírují do cloudu, ale nejčerstvější kousky tam zůstávají. Zařízení tedy slouží i jako cache a drží si kompletní metadata, tedy informace i o objektech, které už nemá a jsou jen v cloudu. Mimochodem dokáže signalizovat klientovi situaci, kdy je cache zcela zaplněna tak, aby to klientovi nijak nevadilo. Pokud se tedy vejdete do cache, kopírování je velmi rychlé. V okamžiku, kdy se celá cache zaplní a data se nestíhají odesílat, zařízení zpomalí zápisy na úroveň vašeho uploadu - kopírování tedy nijak neselže a pokračuje dál.

A co když nakopírujete data jiným způsobem přímo do Blob storage? Budou vidět v Data Box Gateway? Není to sice primární způsob použítí, ale udělat se to dá.

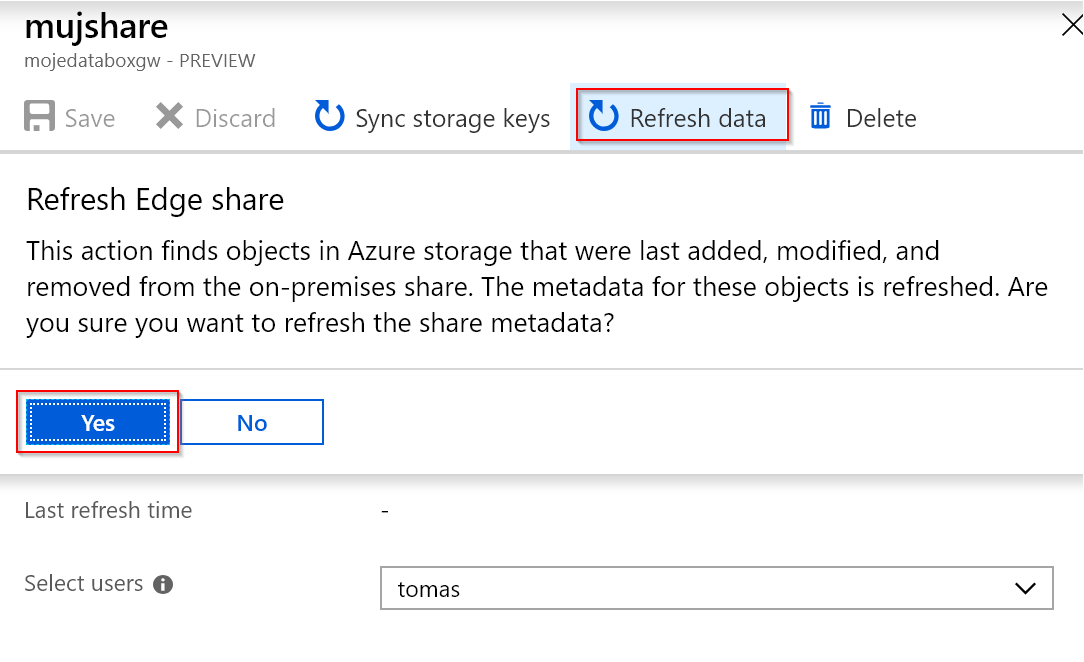

Po nakopírování souboru napřímo jsem kliknul na refresh, což způsobí kompletní synchronizaci metadat se zařízením.

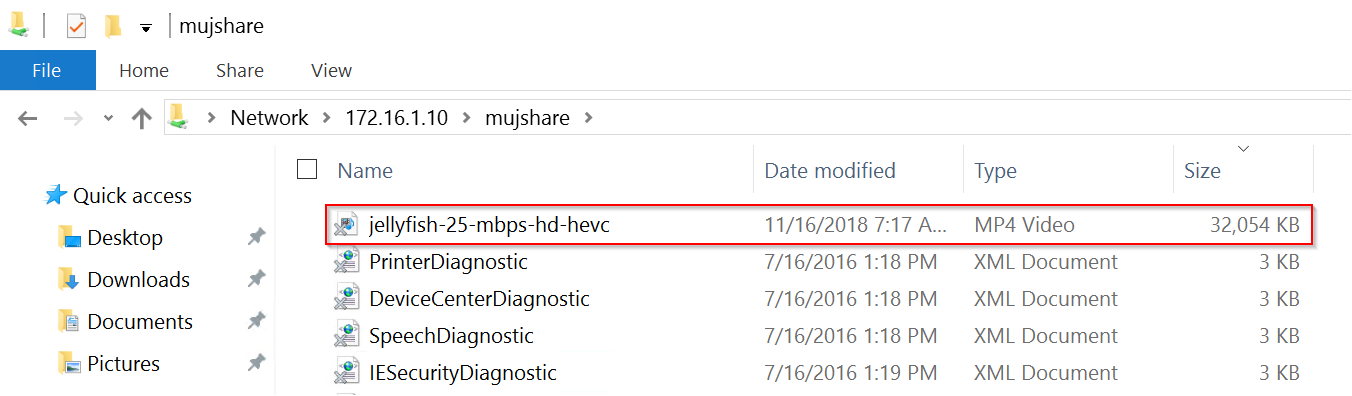

Soubor se tak objevil v mém lokálním share.

Přemýšlíte o tom, jak efektivně kopírovat data do cloudu? Nechce se vám psát skripty a řešit jejich logiku (retry při výpadku spojení, optimalizaci výkonu přes vícero vláken, omezování propustnosti v pracovní době)? Potřebujete něco jednoduchého pro uživatele i aplikace, kde nepotřebují přístup do Azure ani nějaké speciální implementace protokolů? Použijte Azure Data Box Gateway. A pokud to potřebujete někam, kde ani nechcete nic instalovat na svoje servery a potřebujete data před odesláním zpracovat včetně akcelerovaného Machine Learning, pronajměte si Azure Data Box Edge. Objednáte, Microsoft vám pošle hardware, zapojíte a frčíte.